La provincia de Buenos Aires dictaminó por primera vez reglas obligatorias para el uso de sistemas de inteligencia artificial (IA). La resolución se publicó pocos días después de que el municipio de Zárate nombrara a una IA con rango de directora.

Según la nueva normativa publicada en el Boletín Oficial, se regula explícitamente “el desarrollo, elaboración, investigación, innovación, contratación, adquisición, uso y/o despliegue” de IA en todos los organismos provinciales, con el fin de proteger “los derechos y garantías fundamentales de la ciudadanía”.

Además, la resolución de la Subsecretaría de Gobierno Digital, establece que cualquier entidad pública que diseñe, compre o implemente IA deberá cumplir con ciertos estándares de seguridad, transparencia, equidad, sustentabilidad y control humano.

La noticia se conoce días después de que el municipio de Zárate designará a “Zara”, un chatbot, como directora general de Atención al Vecino, con facultades administrativas, firma de documentos y gestión de reclamos.

El caso suscitó cuestionamientos respecto a los límites de su autoridad. Zara funcionaría como una aplicación de inteligencia artificial a nivel municipal, aunque podría existir un vacío legal que requiera evaluar su nivel de riesgo y someterla a auditorías periódicas.

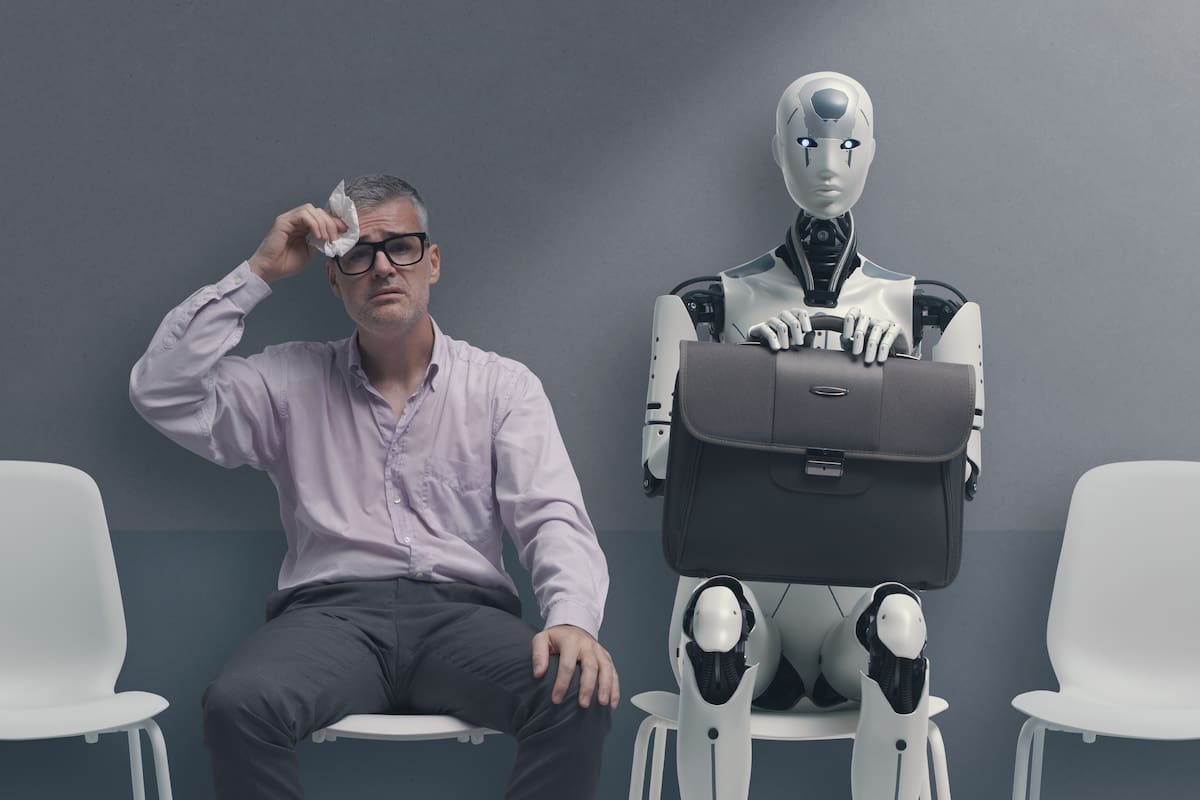

Inteligencia Artificial / robot

Zarate nombró a una Inteligencia Artificial (IA) como nueva funcionaria.

Los Andes

Qué se puede hacer y qué no

Uno de los pilares de la regulación es el enfoque de clasificación basado en niveles de riesgo, inspirado de manera explícita en el marco de la Unión Europea.

La resolución toma como referencia el Reglamento (UE) 2024/1689, conocido como “AI Act”, que entró en vigor en Europa este año. Partiendo de ese antecedente, Buenos Aires establece cuatro categorías de riesgo: inaceptable, alto, limitado y nulo.

Los sistemas considerados de riesgo inaceptable quedan directamente prohibidos. Esto incluye aquellos que puedan comprometer seriamente la seguridad, la salud, los derechos fundamentales o el “orden constitucional-democrático”.

Además, el texto prohíbe el desarrollo de sistemas que utilicen técnicas subliminales o que realicen “clasificación y/o scoring social”, es decir, evaluaciones automatizadas del comportamiento de las personas con fines de control o discriminación.

Esta práctica podría permitir condicionar beneficios públicos o la reputación ciudadana según datos de comportamiento, algo que va en contra del principio de igualdad ante la ley.

En lo que respecta a alto riesgo se encuentran herramientas que podrían impactar derechos individuales de manera directa. Se destacan los sistemas de identificación biométrica, los que gestionan infraestructura crítica, los usados en educación, justicia, empleo, democracia y administración pública.

Los sistemas clasificados como de riesgo limitado, como los chatbots informativos, pueden operar siempre que se cumpla con la transparencia: las personas deben estar informadas de que están interactuando con una máquina.

Finalmente, los sistemas de riesgo nulo —por ejemplo, filtros de spam o automatizaciones internas que no afectan directamente a las personas— solo necesitan seguir buenas prácticas técnicas.

—

fuente: Inteligencia Artificial en Buenos Aires – Los Andes”> GOOGLE NEWS